Pozycjonowanie stron internetowych w wyszukiwarce Google to usługa reklamowana w branży marketingu internetowego jako proces długotrwały, o czym pisaliśmy w poprzednim artykule „Pozycjonowanie to nie jednorazowa usługa”. Oznacza to, że na efekt trzeba najczęściej poczekać kilka miesięcy, jednak w przeciwieństwie do linków sponsorowanych wysokie pozycje utrzymują się zdecydowanie dłużej.

Niestety nie ma jednak gotowej recepty na to, aby w wynikach naturalnych być na pierwszej stronie na pozycjach 1-3 przez cały czas. Nawet jeśli budżet przeznaczany na kampanie SEO jest znacznie wyższy niż konkurencji. Przetasowania w wynikach są rzeczą naturalną, a pozycje zależą najczęściej od skuteczności strategii SEO. W przypadku, gdy nasza domena spada w wynikach o kilka pozycji na jedną frazę nie mamy jeszcze powodów do niepokoju. Co jednak w przypadku, gdy większość fraz, po których byliśmy widoczni na pierwszej stronie nagle znalazło się na piątej czy szóstej stronie wyników? Prawdopodobnie taki nagły spadek pozycji w Google oznaczać będzie zdecydowane zmniejszenie ruchu na stronie, dlatego może się znacząco odbić na rentowności biznesu.

Znalezienie przyczyny spadku pozycji w Google

Pierwszym krokiem po wykryciu znaczącego nagłego spadku pozycji w Google jest zdiagnozowanie przyczyny. Często nie jest to łatwe do zdiagnozowania, mimo, że samo SEO nie musi być trudne do zrobienia. Wyróżnić można 4 podstawowe czynniki, czyli: problemy techniczne związane z nieprawidłowym działaniem strony, zmiana struktury witryny, filtr ręczny od Google oraz filtr algorytmiczny od Google. Przyjrzyjmy się im bliżej.

- Przerwy w działaniu strony – to najłatwiejsza do wykrycia i naprawienia przyczyna spadku pozycji. W przypadku, gdy nasza strona nie działa należy upewnić się czy domena i hosting zostały opłacone w wyznaczonym terminie oraz czy nie ma żadnego problemu z serwerem, na którym postawiona jest nasza strona. Jeśli problem leży gdzieindziej, najprościej poprosić hostingodawcę o backup strony, a więc przywrócenie jej wersji sprzed kilku dni.

- Zmiana struktury strony – spadki mogą występować również w momencie, gdy dotychczasowa strona została diametralnie przebudowana, czyli m.in. zmienił się szablon, pojawiły się nowe adresy URL czy choćby nowe treści. Dlatego też planując przebudowę serwisu zawsze trzeba mieć na uwadze ewentualne konsekwencje w wynikach wyszukiwania.

- Kara ręczna od Google – to bardzo częsta przyczyna nagłych spadków pozycji. W celu sprawdzenia, czy domena została w ten sposób ukarana należy zalogować się do narzędzi dla webmasterów (GWT) i przejść do profilu danej witryny. Następnie kliknąć w „ruch związany z wyszukiwaniem”, a dalej w „działania ręczne”. Jeśli w tym miejscu pojawi się komunikat o nienaturalnych linkach oznaczać to będzie, że zostały podjęte działania wobec witryny, a jej wyniki w wyszukiwarce będą obniżone do momentu aż wskazany problem nie zostanie rozwiązany.

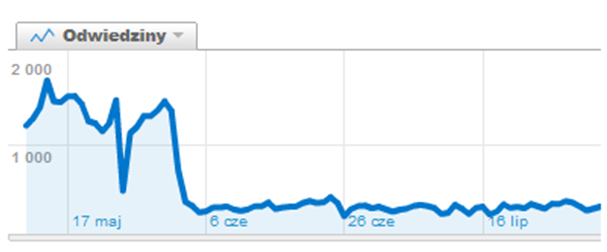

- Filtr algorytmiczny – to przyczyna zdecydowanie najtrudniejsza do wykrycia. Nie pojawia się w tym przypadku żaden komunikat w GWT, a kara nakładana jest automatycznie przez wyszukiwarkę. Najczęściej zdiagnozowanie problemu zajmuje bardzo dużo czasu i oznacza konieczność testowania różnych rozwiązań metodą prób i błędów. Objawem tego filtra jest nie tylko spadek pozycji w wyszukiwarce, ale również charakterystyczny spadek ruchu na stronie.

Rys. Dane z narzędzia Google Analytics wskazujące na znaczący spadek ruchu na stronie.

Jak rozpoznać i poradzić sobie z filtrem algorytmicznym?

O ile z przyczynami nagłego spadku pozycji opisanymi w trzech pierwszych punktach jesteśmy w stanie poradzić sobie mniejszym lub większym nakładem pracy postępując zgodnie ze wskazówkami, o tyle filtr automatyczny nakładany przez wyszukiwarkę może okazać się ogromnym problemem nawet dla doświadczonego Seowca. Problem ten może dotknąć strony zarówno korzystające z pozycjonowania Bydgoszcz jak i ogólnopolskiego, czy globalnego.

Nie ma bowiem żadnych wytycznych od Google, co należy poprawić, aby „rekalkulacja wyników” następnym razem była korzystna dla nas. Poszukiwanie problemu należy każdorazowo rozpocząć od następujących działań:

- Analiza profilu linków – duża ilość linków (na przykład 1500) skupionych wokół zaledwie kilku fraz pozycjonowanych to duży błąd. Jeśli link building opiera się w głównej mierze na dokładnym dopasowaniu linkowanych fraz (archory typu exact match) może to być przyczyna filtra algorytmicznego. Próbując rozwiązać problem należy edytować stare linki dodając do nich również inne an chory (słowa kluczowe). Ponadto warto też dodać nowe linki brandowe (z nazwą firmy) z miejsc o wysokim Trust Ranku, czyli współczynniku zaufania. Pozwoli to zwiększyć zaufanie do strony. W przypadku, gdy większość linków prowadzących do domeny pochodzi z bardzo niskiej jakości serwisów, należy niezwłocznie zaprzestać stosowania tego typu metody zdobywania linków (np. SWL-e) oraz zrzec się niechcianych linków przy pomocy Disavov Tool (niestety może to trwać kilka miesięcy).

- Duplicate Content – problemem wielu witryn jest zduplikowana treść pojawiająca się również w innych miejscach w sieci. Gdy podczas analizy własnej strony wykryjemy za pomocą narzędzi antyplagiatowych, że treści udostępniane przez nasz serwis nie są unikalne, należy natychmiast podjąć odpowiednie działania. Jeśli wina leży po naszej stronie to nie ma wyjścia – należy poświęcić czas na budowę własnego, unikalnego contentu (o wartościowych treściach przeczytać można w artykule „Wysoka jakość treści…”). W przypadku, gdy nasza treść została „wykorzystana” przez kogoś w innych miejscach w sieci bez zgody i wiedzy autora koniecznie należy zażądać usunięcia duplikatu.

- Błędy w skrypcie – filtr algorytmiczny można dostać również w sytuacji, gdy strona zbyt długo się wczytuje. Odpowiedź od serwera z pewnością nie powinna przekraczać 2 sekund i należy tego przypilnować. Podobnie rzecz się ma w przypadku takich błędów jak trojany, wirusy oraz inne ostrzeżenia o szkodliwej witrynie. Jeśli chcemy, aby wyniki wróciły na wysokie pozycje należy pozbyć się tych błędów ze strony,

- Błędny copywriting – bardzo często przyczyną kary od Google jest przesadne przeładowania słów kluczowych w treściach prezentowanych na stronie. Nieumiejętne „przemycanie” słów kluczowych może okazać się szkodliwe, dlatego warto pamiętać o umiarze w zagęszczeniu fraz.

Proces pozycjonowania, w związku z opisanymi wyżej ewentualnymi problemami, należy prowadzić niezwykle ostrożnie. Nie warto zatem próbować tego samodzielnie, by uniknąć nagłych spadków pozycji w Google. Jeśli nie posiada się odpowiedniej wiedzy o możliwych zagrożeniach, można bardzo zaszkodzić firmowej domenie, opóźniając szanse na osiągnięcie wysokiej pozycji na wiele miesięcy.